Gute Miene zum bösen Deal

Mikrobewegungen des Gesichts verraten unsere Gefühle. Was aber wäre, wenn nun Computer sie verstünden? Tun sie schon. Und es herrscht Goldgräberstimmung

In ein paar Jahren könnte das so ablaufen: Jemand sucht neue Sneaker. Er stöbert ein bisschen im Netz rum, besucht Shopping-Portale, schaut sich Anzeigen und Clips von Sportschuhen an. Was er nicht mitbekommt: Da seine Webcam aktiviert ist, werden seine Gesichtsregungen dabei en Detail aufzeichnet. Und beim Schuhhersteller oder Shoppingportal läuft im Hintergrund eine Software, die auswertet, ob die gezeigte Werbung Anklang findet. Lacht der Betrachter? Gähnt er? Verzieht er keine Miene? Wenn er drauf anspringt und die Mundwinkel auch nur einen Milimeter nach oben gehen, wird er vielleicht mit einem 10-Prozent-Gutschein endgültig zum Kauf motiviert.

Die Technologie zur Bestimmung menschlicher Emotionen, die in Zukunft automatisch und ohne Einwilligung des Internetnutzers zum Einsatz kommen könnte, ist von Unternehmen wie „Eyeris“, „Emotient“ oder „Affectiva“ bereits entwickelt worden – und sie verdienen mit der technikgestützten Bestimmung menschlicher Reaktionen auch schon Geld. Auf der „Affectiva“-Website wirbt man damit, dass die firmeneigene Software „Affdex“ bereits 2.624.639 Gesichter in über 75 Ländern untersucht hat. „Wir haben das exakteste Gesichts-Decoding-System entwickelt, das es gibt. Es ist die einzige neurowissenschaftliche Technik, die sich in der natürlichen Umgebung der Teilnehmer anwenden lässt“, heißt es im Imagefilm.

Gegründet wurde das Unternehmen von Wissenschaftlern des renommierten MIT, kurz für Massachusetts Institute of Technology, in Cambridge bei Boston. Wer will, kann sich per eingeschalteter Web-Kamera und Computer auf der Firmennetzseite unterschiedliche TV-Werbespots ansehen. Auf die aufgenommenen Bilder der Betrachter projiziert das System eine Art digitales Gitter und misst die sich verändernden Abstände zwischen Mund-, Augen- und Nasenpartie. Dann wird die Gemütsregung per Datenbankzugriff klassifiziert. So ist schnell erkennbar, ob ein neuer Clip funktioniert oder nicht. Mit derselben Technologie hilft „Affdex“ auch bei der Entwicklung von Filmplots. 219 Zuschauer sahen den Pilotfilm der Serie „Friends with Better Lives“ des amerikanischen TV-Senders CBS. Einige der aufgenommenen deutlichen mimischen Ausschläge halfen später beim dramaturgischen Feinschliff. Aber: Nach nur acht der 13 Episoden setzte CBS die Serie ab. Ein Zeichen dafür, dass die Software dann doch noch nicht so perfekt funktioniert.

Computerprogramme, die die Regungen des Gesichts analysieren und einordnen, basieren auf dem „Facial Action Coding System“, kurz „FACS“. Publik gemacht wurde das System 1978 von den US-Psychologen Paul Ekman und Wallace Friesen. Gut 5.000 unterschiedliche Facetten – mit den jeweils passenden mimischen Regungen – sind bislang klassifiziert worden. Mit dem Decodierungsverfahren werden Gesichtsausdrücke wie Wut, Trauer, oder Freude exakt bestimmt. Selbst Mikroreaktionen erkennt eine Software. Beispiel: Lächelt ein Mensch, so bildet sich das in seinem Gesicht mittels hochgezogener Mundwinkel und einer aktiven Augenpartie ab. Simulieren wir diesen Gemütszustand nur, dann „lächelt“ allein der Mund.

Zu den Kunden, die ihre Werbespots vorab auf Kundenerfolg prüfen, zählen Firmen wie Honda, Procter & Gamble, Coca-Cola und Unilever. Auch ließe sich die Emotionserkennung im Pkw-Bereich anwenden. So könnten Autos per Auslesen der mimischen Regungen des Fahrers mit Hilfe einer Warnlampe einen Pausenhinweis geben. Doch was machen die Unternehmen mit dem Datenschatz, nachdem sie Verhalten und Reaktionen ausgelesen haben? „Affectiva“ will sich dazu nicht genauer äußern und antworten nur knapp: „Wir wissen nicht, was unsere Kunden mit den Profildaten tun.“ Es sind die Anfänge der Computerprogramme, die menschliche Gefühle im Gesicht auslesen können. Spannend ist jedoch die Frage, ob wir uns die Mündigkeit von einer Maschine abnehmen lassen möchten? Was geschieht, wenn Maschinen Fehler unterlaufen, die unser Leben betreffen? Eine unnötige Vollbremsung bei Tempo 200, blitzschnell vom Pkw-System ausgelöst, weil es eine vermeintliche Müdigkeit des Fahrers entdeckte? Und der Wagen deshalb von der Straße abkommt?

Bislang geht es fast nur um die Bewertung von Werbe- oder TV-Inhalten. Doch die Software kann mehr. Ein Blick in die nahe Zukunft: Teilnehmer einer Demo könnten dann mittels Kameras auf anstehende Gewaltausbrüche hin gescannt werden. Sogenannte Mikroexpressionen der Muskeln zeichnen sich im Gesicht ab, bevor die tatsächliche Reaktion zum Ausdruck kommt. So lassen sich Zorn und Empörung frühzeitig erkennen.

Doch was geschieht, wenn die Polizei das Programm bei Befragungen einsetzt und man später deshalb Unschuldige verurteilt? In Deutschland beschäftigt sich Andrea Voßhoff, die Bundesbeauftragte für den Datenschutz und Informationsfreiheit, mit der neuen Entwicklung: „Jeder muss für sich bestimmen, wo und wem er seine Daten preisgibt und ob er möchte, dass andere Profile erstellen können.“ Und weiter: „Ähnlich wie bei Nutzerprofilen besteht die Gefahr, durch eine Videoanalyse bewertet zu werden, ohne dass der Betroffene dies erkennt oder beeinflussen kann. Aber man sollte sich in jedem Fall genau informieren, was da passiert, und sich fragen: Will ich das?“ Über 2,6 Millionen freiwillige Teilnehmer haben sich „Affectiva“ zufolge bereits entschieden. Und verschenkten ihre persönlichen Gesichtsregungen an ein Unternehmen.

Matthias Lauerer (Jahrgang 1975) ist freier Journalist. Er arbeitet unter anderem für den „Stern", "stern.de" und "SPIEGEL ONLINE". Die technischen Entwicklungssprünge bei der Gesichtserkennung haben ihn überrascht. Als er 2000 zum ersten Mal über das Thema schrieb, war der heutige Standard noch undenkbar.

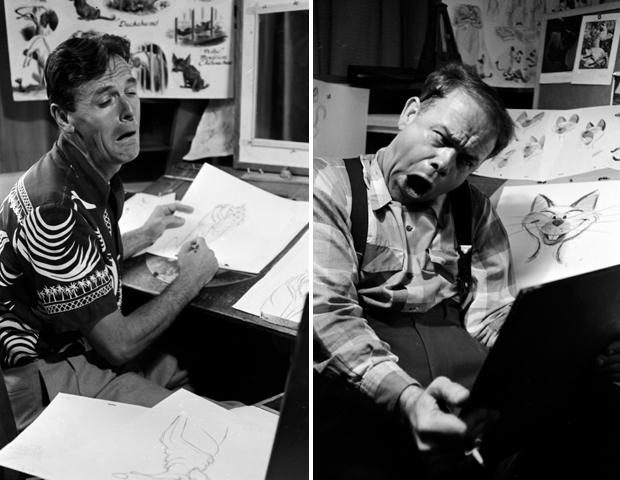

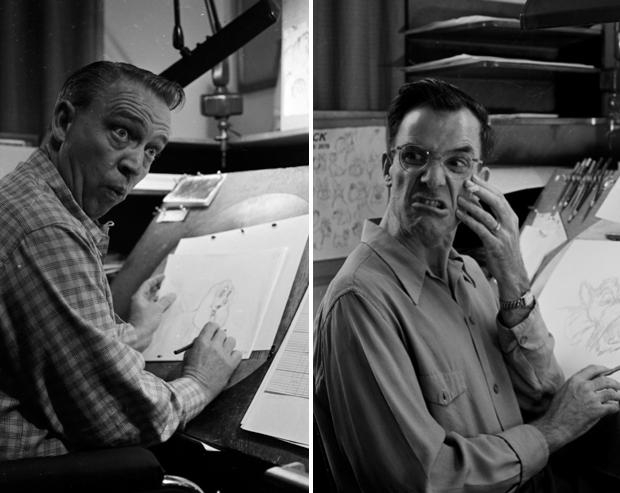

Die Bilder der Grimassen schneidenden Cartoonzeichner hat der Amerikanische Fotograf Alfred Eisenstaedt 1953 in den Ateliers von Walt Disney in Burkank Kalifornien aufgenommen.